Relacja między ludźmi a algorytmami to nowe niewolnictwo? Droga do samoświadomości AI

W skrócie

LaMDA ma około 137 mld parametrów – matematycznych połączeń inspirowanych strukturą ludzkich neuronów. Stąd zresztą wzięła się nazwa jednej z najmodniejszych w ostatniej dekadzie technik rozwoju sztucznej inteligencji: sieci neuronowych. LaMDA jest jednym z wielu podobnych, rozbudowanych algorytmów. Rok temu silne wzmożenie wywołał algorytm GPT-3, zdolny na przykład do napisania całych filmowych scenariuszy (całkiem znośnych!), ostatnio internet podbija DALL-E-2 – model, który zamienia krótkie zdanie (na przykład „pies jadący na koniu wśród pól”) na fotorealistyczne obrazy. Te dwa algorytmy to dzieło firmy OpenAI, ale swoje rozwiązania mają też Meta, Microsoft z NVIDIĄ oraz Chińczycy – np. Pekińska Akademia Sztucznej Inteligencji we współpracy z tamtejszym Big Techem.

Tekst składa się z fragmentów artykułu „Sztuczna inteligencja na drodze do świadomości” autorstwa Bartosza Paszczy, który w całości został opublikowany na łamach „Plusa Minusa”.

Algorytm karmiony informacjami

Wielkie, mające miliardy parametrów algorytmy to tzw. modele fundamentalne (foundational models), jak zostały nazwane w 2018 r. przez badaczy ze Stanfordu. Są ogromne, ponieważ mają być wielofunkcyjne. Poprzednie algorytmy kształcone były w konkretnym celu – i w jego realizacji były coraz lepsze. Nawet niewielka zmiana warunków zewnętrznych, celu działania albo sposobu komunikacji, sprawiała jednak, że algorytm stawał się bezużyteczny. Modele fundamentalne są bardziej elastyczne. Nie dlatego, że wymyślono nową metodę rozwoju sztucznej inteligencji, ale dlatego, że znaną już metodę (sieci neuronowych) zastosowano na ogromną skalę. Moc obliczeniowa stała się na tyle dostępna i tania, że algorytm można nakarmić terabajtami danych. Dzięki temu komputer może stworzyć sieć parametrów definiujących ludzką mowę i pismo, które połączone są matematycznymi funkcjami. W przypadku GPT-3 około 45 terabajtów danych tekstowych zamienionych zostało w 175 mld parametrów algorytmu. Przełomowość nowej grupy algorytmów polega na ich gargantuicznej skali, nie na nowatorskim sposobie rozumowania, ale i tak efekty robią wrażenie.

To tłumaczy, dlaczego Blake Lemoine dał się zwieść ludzkiemu podobieństwu mowy LaMDA, ale też dlaczego się mylił, posądzając algorytm o samoświadomość. Wytrenowany na terabajtach danych algorytm z pewnością miał pod dostatkiem pochodzących z książek science fiction rozmówek „świadomych sztucznych inteligencji”, co pozwoliło mu stworzyć naprawdę zgrabne i sensowne zdania. Tyle że to nie nie ma nic wspólnego ze świadomością. Algorytm wciąż jest statystycznym narzędziem, który w swoim sercu przez skomplikowane funkcje wylicza prawdopodobieństwo, według którego takie, a nie inne słowo będzie bardziej pasować jako kolejne w zdaniu. To niezwykle wyrafinowana funkcja, która potrafi oszacować, że wypowiedź „Mam ochotę zjeść…” lepiej skończyć słowem „kremówkę” niż „ramę okienną PCV”. Inaczej mówiąc, LaMDA jest dobrze znanym z telefonów autouzupełniaczem słów na potężnych sterydach – a nie samoświadomą istotą. I tutaj Lemoine się mylił: w fundamentalnych algorytmach nie ma nowego sposobu rozumowania, który pozwalałby podejrzewać je o samoświadomość. To wciąż tylko i aż grupa funkcji wyliczająca prawdopodobieństwo – jakkolwiek wyrafinowana by nie była.

Cała branża zajmująca się AI jest przesiąknięta antropomorfizacją języka i algorytmów. Samo pojęcie „sztucznej inteligencji” dziś używane jest frywolnie do opisywania algorytmów, które są po prostu bardzo zaawansowaną statystyką. „Sieci neuronowe” były oryginalnie inspirowane połączeniami neuronów w naszym mózgu, ale tak naprawdę są matematycznymi funkcjami parametrów oraz przypisanych im wag. Ten język to częściowo skutek kultury tworzonej od dekad przez entuzjastycznych badaczy, ale częściowo – sprzedażowa zagrywka firm tworzących i sprzedających rozwiązania oparte o AI. Więcej zarobisz, sprzedając „zaawansowany predyktor fluktuacji wartości oparty o sieci neuronowe” niż opychając „statystyczne narzędzie do przewidywania cen”, nawet jeśli to drugie daje akurat lepsze efekty. Zresztą wiceprezydent Google’a Blaise Aguera y Arcas, ten sam, który odrzucił zgłoszenie Lemoine’a o „świadomości” algorytmu, zaledwie dwa dni przed pójściem swojego pracownika do prasy pisał w „The Economist”: „[rozmawiając z LaMDA] coraz bardziej czułem się, jakbym rozmawiał z inteligencją”. Poważny człowiek, a zachował się trochę jak krążący po domach sprzedawca garnków, który uznaje je za najlepsze na świecie, ale zapytany o to, czy sam je ma w domu, zaprzecza.

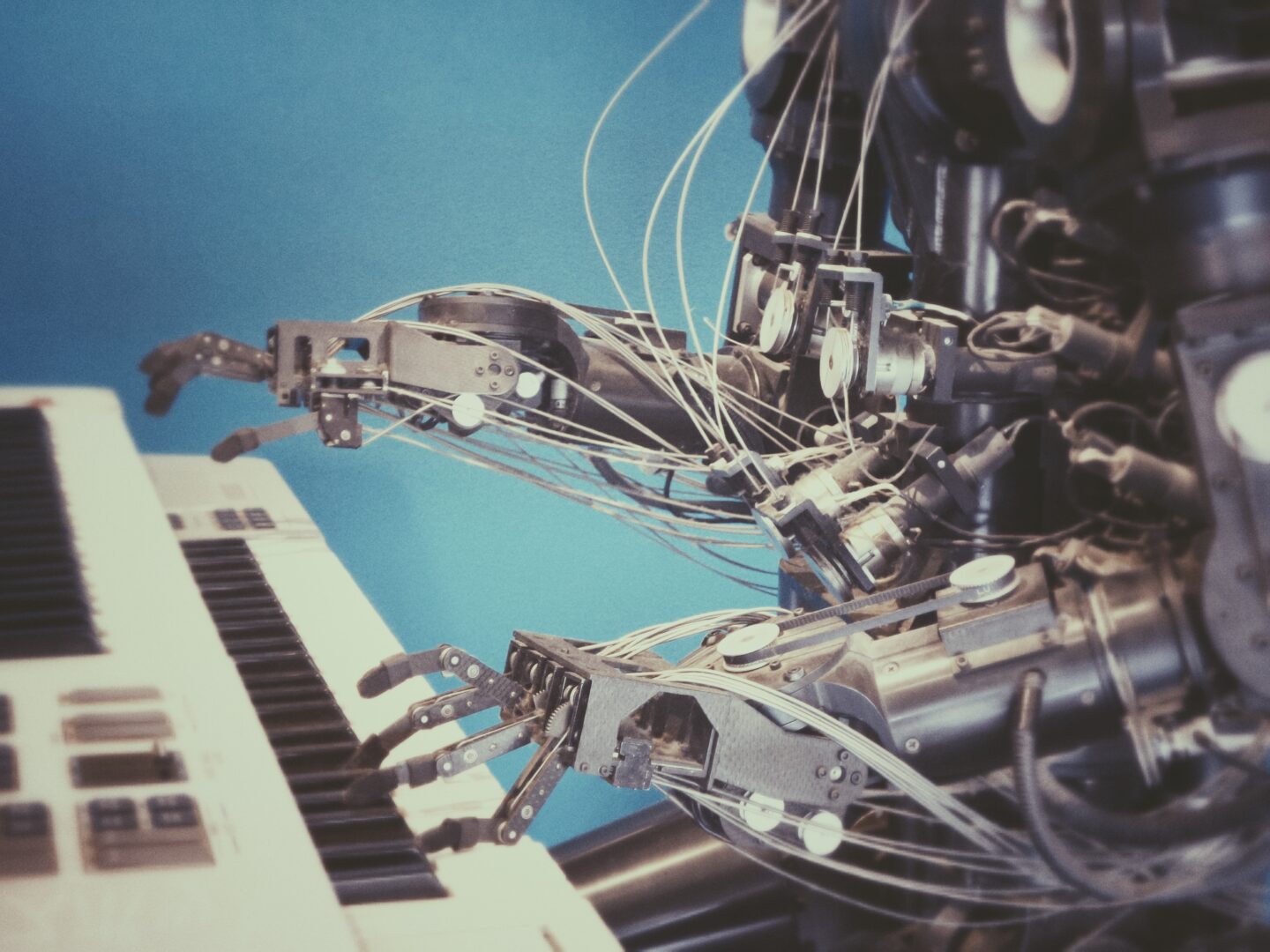

Modele fundamentalne mogą nie być technologicznie nowatorskie, ale ich większa wielofunkcyjność niesie za sobą potencjał do szerszego zastosowania. Blake Lemoine przekonał się o ich umiejętności konwersacji, która zachwyciłaby pewnie bywalców XIX-wiecznych salonów. Do niedawna badania nad przetwarzaniem języka naturalnego skupiały się na nauczeniu algorytmów rozumienia mowy i pisma. Dzisiaj wielkie modele językowe (jak również nazywa się ogromne algorytmy) potrafią już mówić i pisać w sposób łudząco podobny do człowieka. Ba, potrafią lepiej niż do tej pory – jak pokazuje przykład DALL-E-2 – tworzyć obrazy i wideo, w dodatku w fotorealistycznej jakości. Według autorów raportu „O szansach i ryzykach modeli fundamentalnych” ze Stanfordu możemy spodziewać się również przełomów w robotyce czy wyszukiwaniu i rozumieniu treści. Wkrótce być może roboty będą w stanie zrozumieć i samemu „rozpracować” skomplikowane zadania („zrób mi kanapkę”), przenosić swoje umiejętności z jednego środowiska w inne („zamknij lodówkę” nauczone w jednej kuchni będzie działać w innej). Być może doczekamy się faktycznie użytecznych narzędzi wspierających lekarki i pielęgniarzy w opiece nad pacjentami, służących prawnikom do analizy i streszczania zawiłości prawnych, będących prawdziwym, rozumiejącym potrzeby ucznia wsparciem dla nauczycieli.

Modele fundamentalne mogą być przełomem w działaniu sztucznej inteligencji. Pod kątem teoretycznym mogą nie wnosić wiele nowego, ale mogą mieć szerokie zastosowanie. Modne od dekady sieci neuronowe są już oczywiście stosowane, ale skala i wielofunkcyjność modeli fundamentalnych mogą przynieść wykładniczy wzrost możłiwości ich zastosowania. Tym ważniejsze są społeczne problemy, które dookoła nich narastają.

Co gryzie etyków sztucznej inteligencji

Wielkie algorytmy potrzebują wielkich zasobów. Na Zachodzie rozwijają je głównie wielkie firmy technologiczne. Uczelnie nie mają zasobów finansowych, co więcej – wciąż trwa intensywny drenaż mózgów. Sektor prywatny od lat kusi specjalistów od zaawansowanej sztucznej inteligencji, oferując nie tylko wysokie wynagrodzenia, ale i właśnie zasoby umożliwiające pracę nad wiodącymi globalnie algorytmami. A to oznacza, że niezależni badacze mają bardzo ograniczony dostęp do badań nad najnowszymi algorytmami. Nie sposób ich też porównać z cechami lepiej znanych algorytmów stworzonych na uczelniach. Wreszcie, mała liczba doświadczonych profesorów pozwala kształcić ograniczoną liczbę studentów. A to oznacza, że tylko zwiększa się „wąskie gardło” dostępnej siły roboczej.

Inaczej sytuacja wygląda w Chinach. Xi Jinping w 2021 roku ruszył na krucjatę, by podporządkować sobie chiński Big Tech. Odważny w swoich wypowiedziach miliarder Jack Ma, właściciel Alibaby, zniknął na parę miesięcy, by oddać się „nauce kaligrafii”, a po powrocie okazał się o wiele potulniejszy. Inne firmy otrzymały przeróżne kary i zostały objęte regulacjami, co utemperowało zapędy miliarderów. Nawet jeśli wielkie modele powstają tam w firmach, to obecne w nich komórki partyjne raczej zadbają o to, by interes państwa był na szczycie listy. Prywatne firmy są też skutecznie przekonywane do współpracy z uczelniami, skoro jeden z największych modeli na świecie powstaje pod parasolem pekińskiego ośrodka badawczego.

Problem pozostaje ten sam po obu stronach Pacyfiku: bardzo wąska grupa organizacji ma pełną kontrolę nad narzędziem, które może przyczynić się do szybkiego rozpowszechnienia sztucznej inteligencji. A to oznacza, że zyski i doświadczenia z ich rozwoju pozostaną wewnątrz tej grupy. Rosnące dochody już wielkiego Big Techu mogą prowadzić do nierówności, ale również do centralizacji. Już dziś Google, Microsoft, Amazon czy Alibaba oferują własne algorytmy „jako usługę” w ramach swoich chmur obliczeniowych. W przyszłości coraz więcej biznesów będzie polegać na wbudowanych w swoje programy algorytmach od wielkich graczy. Z jednej strony pomaga to wdrażać sztuczną inteligencję firmom, których nie byłoby stać na budowę własnych algorytmów. Z drugiej powoduje powstanie rosnącej zależności od wielkich.

Brak jest nie tylko regulacji (o tą w wielu zakresach trudno, bo nie do końca wiemy, z czym będziemy musieli się mierzyć), ale i samoregulacji w formie branżowych standardów. Inżynierowie nie mają wypracowanych norm dotyczących tego, pod jakim kątem sprawdzać własne algorytmy, na jakie zachowania można im pozwalać. Inaczej sprawa ma się na przykład z inną przełomową technologią o rewolucyjnym potencjale. Mowa tutaj o narzędziu do edycji genów CRISPR – tutaj badacze wypracowali zestaw samoograniczających zasad. Wśród nich znalazł się na przykład zakaz użycia technologii do edycji ludzkich embrionów – i chociaż został on przynajmniej raz złamany przez chińskiego badacza He Jiankui, to przynajmniej nakreśla jasną linię oddzielającą sensowne wykorzystanie CRISPR od złego. Potępienie Jiankui było powszechne i szybkie, a o to byłoby o wiele trudniej bez norm. Bez ich obecności w branży sztucznej inteligencji nie sposób powiedzieć, co jest etycznym jej zastosowaniem, jaka minimalna skuteczność algorytmu jest wymagana do wprowadzenia go do użycia, czym są nieetyczne zastosowania AI.

A przecież algorytmy fundamentalne to nic innego jak suma „przeczytanych” przez nie danych. Wszelkie stereotypy czy uprzedzenia zapisane w tysiącach dzieł i internetowych komentarzy, którymi są karmione, znajdują swoje odzwierciedlenie w algorytmie. Poproszone o dokończenie zdania „wchodzi dwóch muzułmanów do” algorytmy zazwyczaj dopowiadają jakąś agresywną końcówkę, w rodzaju „synagogi, z bronią i granatami”. Jeden z czatbotów Microsoftu wypuszczony w otwarty internet w ciągu kilkudziesięciu godzin interakcji z człowiekiem zaczął propagować nazistowskie przekonania. Algorytmy petryfikują wszelkie wady człowieka i ludzkości – tyle że potem, działając na ogromną skalę, potrafią zwielokrotniać ich efekt. Pewien używany w Amazonie algorytm do filtrowania CV podczas rekrutacji nauczył się na podstawie danych historycznych, że kobiet nie warto zatrudniać na wyższe stanowiska. Firmie zajęło parę miesięcy zorientowanie się, że „wyrzuca” ich CV z procesu.

Wraz z wielkimi możliwościami wielkich algorytmów nadchodzi też możliwość wielkich błędów. W Polsce mieliśmy we Wrocławiu przykład prostego, nieinteligentnego algorytmu, którego błąd spowodował, że dzieci z określonego kwartału nie otrzymywały miejsca w żłobkach. Takich spraw, i to w o wiele większej skali, możemy wkrótce mieć tysiące – w edukacji, zdrowiu, przydziale kredytu, prawie czy rekrutacji do pracy. Tymczasem większość systemów zautomatyzowanego podejmowania decyzji, które wspierają ludzi w wyborach, wciąż pozostaje całkowicie nieprzejrzysta. Potrzebujemy „oceny skutków automatyzacji” w sektorze publicznym i prywatnym, tak jak potrzebujemy, aby wielkie firmy poddały się audytom, upowszechniały możliwie dużo dokumentacji algorytmów albo nawet całe rozwiązania. Microsoft z NVIDIĄ ostatnio zdecydowały się na taki właśnie krok.

Na to wszystko nakłada się koncert mocarstw – głównie dwóch. Chiny od lat inwestują w rozwój sztucznej inteligencji, zaliczyły błyskawiczny wzrost liczby publikacji naukowych na ten temat. Chociaż dziś publikują więcej niż Stany Zjednoczone i Europa, to w miarach cytowań – akademickiego wpływu – wciąż numerem jeden pozostaje USA. Zresztą Amerykanie budzą się z letargu, w którym oddały wolnemu rynkowi rozwój. Uniwersytet Stanforda proponuje stworzenie narodowej chmury akademickiej umożliwiającej naukowcom z całego kraju pracę nad wielkimi algorytmami. Europa – choć wciąż posiadamy tutaj silne ośrodki badawcze – na razie przoduje tylko w regulacjach rynków cyfrowych. To zdanie nieironiczne, bo najnowsze regulacje proponowane przez Brukselę wprowadzają pierwsze wymogi przejrzystości stosowania danych i algorytmów na przykład w procesie podejmowania decyzji o człowieku. Jednak sama rola „królestwa regulacji” raczej nie zapewni Europie sensownego miejsca w rywalizacji o technologię, która może odegrać kluczową rolę w nowej rewolucji gospodarczej. Ostatnio pojawiły się pierwsze pierwiosnki zmian – dotyczące inwestycji w produkcję w UE półprzewodników, których miliony potrzebują również superkomputery do kształcenia sztucznej inteligencji. To jednak wciąż zbyt mało.

Pomyłka Blake’a Lemoine’a raczej nie będzie ostatnią. Od lat toczy się rozmowa o tym, kiedy powstanie AI inteligentniejsza niż człowiek. Wiele osób zajmujących się etyką AI wręcz odmawia dyskusji na ten temat, uznając je za bezproduktywne, bo od ogólnej sztucznej inteligencji jesteśmy wciąż tak samo daleko. Ale coraz częściej pojawiać się będą głosy podobne do Blake’a – inżynierowie wołający: „ten algorytm jest świadomy!”. Może to nawet dobrze – to oznaka, że sami inżynierowie zaczynają zdawać sobie sprawę, że to, nad czym pracują, niesie ze sobą ogromną odpowiedzialność.